Oznacza to, że tworzą białą plamę dla największej wyszukiwarki świata i nawet wnikliwym poszukiwaczom treści nie objawią się w Google. Problem białych plam Internetu rozwiązuje optymalizacja crawl budget. Problematyka zarządzania nim jest o tyle istotna, że w przeciągu ostatnich lat zalecenia specjalistów SEO bardzo się zmieniły. Praktyka wskazuje, że rozwiązania stosowane do tej pory przestały przynosić oczekiwane rezultaty. Jak zatem zrobić to poprawnie?

Roboty Google’a, które stale krążą po Internecie, mają niemałe zadanie. Tak chyba można nazwać analizę największego zbioru informacji w dziejach ludzkości, jakim jest Internet. Roboty te „pełzają” przez kolejne adresy URL serwisów i skwapliwie dodają do swojego indeksu informacje, jakie znajdą. Dzieje się tak dwadzieścia cztery godziny na dobę, siedem w dni w tygodniu. Można założyć, że będzie się tak działo do końca istnienia Internetu, wyszukiwarki Google’a albo nas samych…

Zobacz również

W taki sposób wyszukiwarka Google poznaje odpowiedzi na ważne dla niej pytania: Jaka zawartość tekstowa znajduje się w opublikowanym artykule z naszego bloga firmowego? Jakie konkretnie produkty znajdują się pod kategorią „Gry Planszowe” w naszym sklepie internetowy? Co zmieniło się ostatnio na głównej stronie kategorii „Róże” w naszym serwisie o pielęgnacji roślin?

Czym jest crawl budget?

Oczywiste jest, że nie wszystkim podstronom Google jest w stanie zapewnić taką samą uwagę. W takich wypadkach należy zastanowić się nad optymalizacją crawl budget naszego serwisu. Definicja tego pojęcia jest następująca: crawl budget to suma stron, jakie roboty Google’a będą chciały zaindeksować w danym serwisie. W przypadku niezoptymalizowanego crawl budget część naszego serwisu będzie nieznana Google’owi. Zatem część podstron nie będzie uczestniczyć w konkurencji o najlepsze pozycje wyszukiwania. Poddajemy się wówczas walkowerem i robimy to nieświadomie. W ten sposób pozostałe nasze działania SEO nie przynoszą efektów.

Crawl budget a widoczność w Google

Czy za 12 miesięcy SEO będzie organiczne – czy tylko „sztucznie inteligentne”? [OPINIE]![Czy za 12 miesięcy SEO będzie organiczne – czy tylko „sztucznie inteligentne”? [OPINIE]](https://nowymarketing.pl/wp-content/uploads/2025/06/Projekt-bez-nazwy-34_Easy-Resize.com_-142x0-c-default.jpg)

Portale, które mają problem z zarządzaniem crawl budgetem, odnotowują charakterystyczne zmiany w widoczności w Google. A w zasadzie ich brak, mimo podejmowanych działań optymalizacyjnych. Deweloper wprowadza potrzebne poprawki techniczne w kodzie strony, copywriter pisze poczytne i wyczerpujące materiały, a dział PR pozyskuje bezcenne linki do naszej strony na serwisach docenianych przez Google. Wszystkie te działania odbywają się pod batutą specjalisty SEO. Problem jednak jest taki, że mimo najszczerszych wysiłków wprowadzone zmiany nie przynoszą oczekiwanego rezultatu. Tak jakby nad nami wisiał szklany sufit, który powstrzymuje wzrosty ruchu organicznego.

Słuchaj podcastu NowyMarketing

Jeżeli powyższą obserwację można odnotować w przypadku dużego serwisu, to należy się zastanowić czy nie bombardujemy robotów Google’a zbyt dużą liczbą podstron. W takiej sytuacji za najwyższy priorytet działań SEO powinniśmy uznać optymalizację crawl budgetu, czyli po prostu ograniczenie liczby niepotrzebnych podstron. To praca wymagająca, zazwyczaj oznacza to konieczność usunięcia i przekierowania części adresów URL, jakie widnieją w serwisie.

Polityka „One Keyword, One Page”: historia wzlotu i upadku

Przyznać trzeba, że swego czasu sprawę skomplikowali sami specjaliści SEO. Niniejszy artykuł, w którym zachęcamy do „odchudzania” serwisów, jeszcze kilka lat temu zostałby uznany za herezję. Zapewne do dziś jeszcze ostali się specjaliści, którzy nie zrewidowali skuteczności swoich dotychczasowych zaleceń i dalej brną w strategię „One Keyword, One Page”. Na czym ona polega? Otóż przez wiele lat zalecało się coś przeciwnego niż redukcję małowartościowych adresów URL. Zamiast „odchudzania” serwisów zwiększano liczbę podstron. Tak, aby każda strona była wyspecjalizowana w jednej, konkretnej frazie. Stąd właśnie bierze się chwytliwa nazwa tej strategii.

Przykład? Polityka „One Keyword, One Page” zakładała stworzenie osobnych stron sklepu internetowego pod zapytania: „szpilki”, „czarne szpilki”, „czarne lakierowane szpilki”, „czarne lakierowane szpilki z czerwoną podeszwą” i tak w nieskończoność. Mamy na oku jakąś, choćby najbardziej niszową frazę kluczową? Od razu tworzymy osobną podstronę bezpośrednio pod tę frazę.

Dlaczego odchodzimy od modelu „One Keyword, One Page”? Pierwsze przesłanki o konieczności zaniechania tej strategii pojawiły się w momencie zmiany algorytmu Google’a w 2013 roku. Był to moment wprowadzenia tzw. Kolibra. Była to istotna zmiana w „silniku” wyszukiwarki. Jej celem było rozumienie sensu zapytania, zamiast zbioru poszczególnych wyrazów. Od tego momentu Google odchodziło od prezentowania wyników, które pokrywają się wyłącznie 1:1 ze słowami wpisanym w okno zapytaniem. Kolejną czerwoną kartką dla mnożenia podstron było udoskonalenie Google’a o algorytm „BrainRank” w 2015 roku. Zmiana ta polegała między innymi na lepszym rozumieniu intencji użytkowników. W tym także tego, że mimo bardzo różnorodnej artykulacji naszych problemów, możemy szukać tak naprawdę tej samej rzeczy.

Wpływ tych zmian na serwisy typu „One Keyword, One Page” nie był natychmiastowy. Na przestrzeni lat zaczęły pojawiać się jednak sukcesywnie efekty zmian, jakie wprowadziło Google. Przerośnięte serwisy zaczęły pozostawać w tyle za tymi bardziej okrojonymi. Takimi, które nie bombardują już robotów Goolge’a dziesiątkami tysięcy podstron oraz nie rozmieniają frazy kluczowej „na drobne”. Świetnym tego przykładem było opisywane przez Juana Gonzaleza starcie w niemieckim Google z 2019 roku. Odbyło się ono pomiędzy Hometogo.de a Airbnb.de. W jego wyniku pierwsza ze stron, o wiele mniejsza od drugiej, dotrzymała kroku międzynarodowemu gigantowi. W skrócie: w zeszłym roku Hometogo.de posiadał tylko 5.200 zaindeksowanych adresów URL, podczas gdy jego konkurent miał ich 1.300.000! Mimo tych dysproporcji wedle narzędzia Ahrefs, mniejszy z serwisów był widoczny na 9.069 fraz w pierwszej trójce wyników Google. Konkurencyjne Airbnb.de może pochwalić się wynikiem niemal podobnym: 10.300 fraz w tzw. TOP3. Co prawda, w przypadku obecności wśród pierwszych dziesięciu wyników w Google (czyli „TOP10”) przewaga większego serwisu jest bardziej wyraźna. Wynosi ona 44.463 do 29.844 na korzyść Airbnb.de. Jednak należy pamiętać, że w branży turystycznej szczególnie istotne są właśnie pierwsze trzy wyniki wyszukiwania. Ponadto przewaga Airbnb.de w przypadku „TOP10” też nie jest miażdżąca.

Zalecenia specjalistów SEO z poprzednich lat nie wynikały z braku wiedzy o wyszukiwarce Google. Takie działanie swego czasu miało jak najbardziej sens, bo przynosiło wymierne efekty klientom. Jednak po 2013 roku rozwój technologiczny spowodował, że strategia „One Keyword, One Page” musiała odejść do lamusa.

Odejście od polityki „One Keyword, One Page” – pułapki

Postulat odejścia od tej strategii SEO niesie ze sobą ryzyko wpadnięcia w dwie pułapki. Po pierwsze, nie można wyciągnąć pochopnego wniosku, że „im mniej podstron tym lepiej dla serwisu”. Taki wniosek prowadziłby nas do logicznego, ale fałszywego wniosku, że wszędzie powinniśmy stosować serwisy typu one-page. Ograniczanie liczby stron w serwisie nie jest celem samym w sobie. Naszym celem jest wyłącznie pozbycie się stron, których treść można byłoby spokojnie zawrzeć na jednym, ogólniejszym adresie URL.

Po drugie, nie oznacza to, że serwis nie powinien pozycjonować się na bardziej szczegółowe frazy kluczowe. W branżowym żargonie nazwanymi „długim ogonem”. Nadal powinien to robić, jednak za pomocą ogólniejszych tematycznie podstron. Wróćmy do naszego przykładu obuwniczo-modowego. Chcemy pojawić się w wynikach na zapytanie „czarne lakierowane szpilki z czerwoną podeszwą”? Nie potrzeba nam zatem nowej podkategorii o takiej właśnie nazwie. Szczególnie, jeżeli w naszej ofercie nie ma wielu produktów, które spełniają takie warunki. Wystarczy, że poprzestaniemy na istnieniu kategorii „szpilki z czerwoną podeszwą”. Takie zapytanie użytkowniczki Goolge’a wpisują średnio 400 razy miesięcznie! Taki wynik powoduje, że osobna podkategoria ma sens. Jednocześnie warto uwzględnić frazę „czarne lakierowane” w tekście na stronie. Można też wziąć to pod uwagę podczas linkowania zewnętrznego. W rezultacie uda nam się spozycjonować adres URL tej podkategorii także pod hasło „czarne lakierowane szpilki z czerwoną podeszwą”.

Serwisy „puchną” też same z siebie

Nie zawsze niezoptymalizowany crawl budget jest następstwem polityki „One Keyword, One Page”. Równie dobrze może być to wynik nieświadomych decyzji, jakie zostały podjęte na etapie projektowania serwisu. W rezultacie nowy serwis może być z góry skazany na za dużą liczbę podstron. Jest to oczywiście argument za tym, aby już na etapie tworzenia nowej strony włączać specjalistów SEO.

Często zdarza się także, że serwisy rozrastają się w niewłaściwym kierunku za sprawą braku spójnej polityki stron tagowych. Dzieje się tak w przypadkach, gdy mamy kilkuosobową redakcję portalu i pozostawimy każdego z autorów z własną decyzją co do kształtu nowych tagów. Prędzej czy później dochodzi wówczas do dublowania tagów (na przykład funkcjonowanie równocześnie tagów „SEO” i „Search Engine Optimization”) oraz tworzenia tagów, które będą obecne tylko na tym jednym artykule (słynny już tag „Libacja na skwerku we Wrocławiu” :)).

Miałem okazję zetknąć się z serwisem, który takich pustych stron tagowych posiadał łącznie 2.000. Co gorsza interfejs portalu pozwalał dzielić te adresy URL na jedną z pięciu podkategorii. W rezultacie dawało to równe 10.000 adresów URL, po których bezcelowo błąkał się robot Google’a. Przy tak dużej liczbie małowartościowych podstron również można mówić o ich negatywnym wpływie na crawl budget całego serwisu.

Czy moja strona jest przerośnięta?

Skoro wiemy już, na czym polega problem, możemy sprawdzić, czy dotyczy on naszego portalu. Pierwsze kluczowe pytanie, na które powinniśmy sobie odpowiedzieć, brzmi: z ilu dokładnie podstron składa się nasz serwis? Na szczęście obliczenia w tym kierunku nie muszą sprowadzać się do oddelegowania do pracy stażysty. Z pomocą narzędzi crawlujących jak „Screamin Frog”, „Deep Crawl” albo „WebSite Auditor” jesteśmy w stanie zapoznać się z całym naszym stanem posiadania.

Następnie zebrane dane należy skonfrontować z naszą analityką webową. Choćby tą, jaką zapewnia nam Google Analytics. Ile z tych wszystkich stron odnotowało wejścia z wyszukiwarki w przeciągu ostatniego roku? Jeżeli około 90% z nich nie odnotowało żadnego ruchu organicznego, to mamy przed sobą niepokojący sygnał. Możliwe bowiem, że Google w ogóle nie dotarło do części z tych stron.

Stan indeksu w Google Search Console

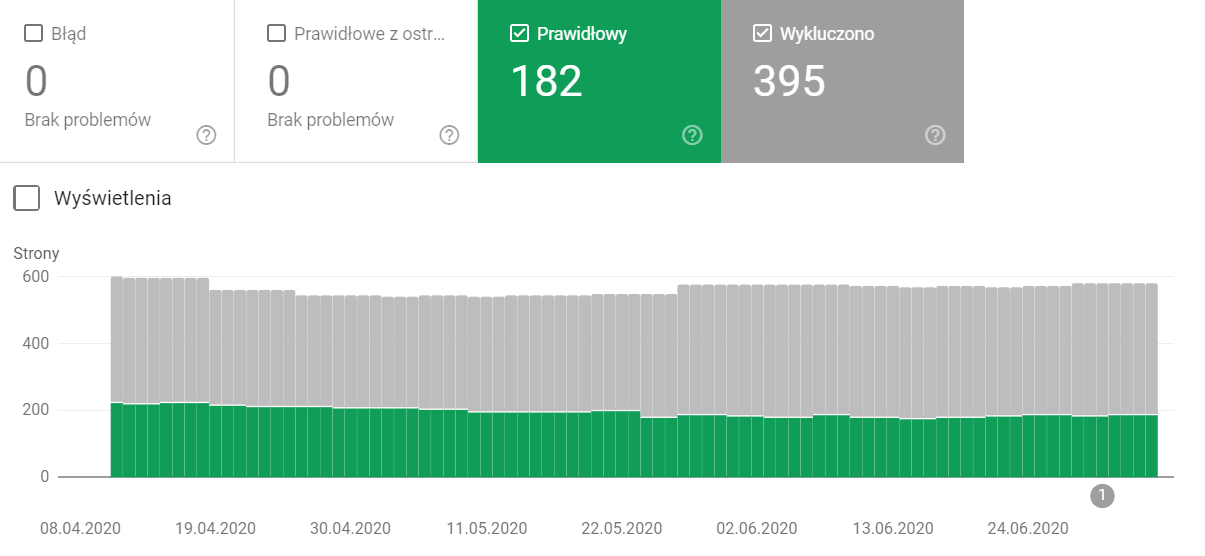

Kolejnym obowiązkowym narzędziem do analizy portalu jest Google Search Console. Ta platforma jest pośrednikiem pomiędzy wyszukiwarką Google’a a właścicielami serwisów. Dostarcza nam ona wielu bardzo istotnych informacji. W tym przypadku niezastąpiony jest raport o stanie indeksacji naszej witryny (Indeks > Stan):

Screen z raportu: Google Search Console

Możemy w nim zbadać, jaki jest stosunek pomiędzy stronami dodanymi do indeksu („Prawidłowy”), a świadomie pominiętymi przez Google („Wykluczony”). Wśród tej drugiej kategorii interesujące są szczególnie grupy: „Strona wykryta – obecnie niezindeksowana” oraz „Strona zeskanowana, ale jeszcze niezindeksowana”. Po ich wybraniu zobaczymy listę wszystkich stron, które wykryły roboty Google’a, jednak nie dodały ich do indeksu. Dlatego, że zabrakło na to mocy wyszukiwarki. Pozwoli nam to zobaczyć skalę problemu z crawl budgetem.

Należy przy tym pamiętać, że istnieje część naszych stron, których nie ma nawet na wspomnianych listach GSC. Są to strony, o których istnieniu roboty Google’a kompletnie nie mają pojęcia. O rozmiarze tej grupy możemy dowiedzieć się, zestawiając dane z GSC z faktyczną liczbą podstron w naszym portalu.

W jaki sposób zoptymalizować crawl budget?

Trudno mówić o jednym, precyzyjnym planie optymalizacji crawl budgetu. Wszystko zależy od rozmiaru problemu, konstrukcji serwisu oraz kolorytu branży, w której funkcjonuje nasz klient. Wdrażanie uniwersalnych rozwiązań nie jest dobrym pomysłem. Optymalizacja crawl budgetu nie jest bowiem niczym innym jak „amputacją” części naszego portalu. Zrozumiałe jest, że przed taką operacją należy się dwa razy zastanowić. Powyższe różnice mogą natomiast przesądzić o użyteczności lub jej braku dziesiątek tysięcy podstron. Zamiast tego można powiedzieć o uniwersalnych krokach, przez jakie powinna prowadzić współpraca specjalista SEO z właścicielem strony obciążonej niezoptymalizowanym crawl budgetem.

Po pierwsze konieczne jest przeprowadzenie kompleksowej analizy stanu contentowego portalu. Strategia contentowa dla serwisu pozwala specjaliście SEO zaznajomić się z problemem, a także lepiej poznać branżę, w której funkcjonuje strona.

Po drugie konieczne będzie przygotowanie kohort. Pod tym pojęciem rozumiemy podzielenie wszystkich adresów wedle ich przydatności na stronie i ryzyka związanego z ich usunięciem. Strony można podzielić na przykład na cztery części: do usunięcia bez żadnego ryzyka dla widoczności SEO; do usunięcia przy minimalnym ryzyku dla widoczności SEO; strony do dalszej obserwacji; podstrony do pozostawienia na stronie. Kohorty pozwalają nam na łagodniejsze wprowadzanie zmian na stronie. Tak, aby zrobić to za pomocą sukcesywnych zmian zamiast dużej, natychmiastowej rewolucji.

Kolejnym krokiem jest przygotowanie planu, na jakie konkretnie strony mają zostać przekierowane usunięte adresy. W tym momencie trzeba zaplanować, w jaki sposób muszą się one zmienić, aby były w stanie pozycjonować się na frazy „z długiego ogona”.

Dopiero po przeprowadzeniu trzech powyższych kroków możemy przekazać do dział deweloperów wykonanie przekierowań. Ich działanie polegać będzie na usunięciu wskazanych adresów, przekierowaniu ich na określone strony, ale także zatarciu śladów po usuniętych stronach.

Zagrożenia – czyli „odchudzanie” bez efektu jo-jo

Proces „odchudzania” strony jest niebezpiecznym przedsięwzięciem. Nie możemy podczas niego zdać się na przypadek. Kluczowe będzie tu nie tylko wskazanie do usunięcia właściwych podstron, ale także umiejętne zweryfikowanie operacji przeprowadzone przez dewelopera. Tak, aby ostatecznie nie pozostawić serwisu w stanie niedokończonej migracji. Specjalista SEO monitorujący przebieg prac musi upewnić się, że:

- Przekierowane zostaną wyłącznie strony, które zostały wskazane w kohortach jako zbędne;

- Każdy adres wskazany do przekierowania został przekierowany na stronę wskazaną w strategii migracji;

- Przekierowania prowadzić będą bezpośrednio pod wskazany adres, a nie pod jego wariant (na przykład jego wersji HTTP, czy wersji adresu bez „www”);

- Wszystkie wykonane przekierowania będą działać za pomocą kodu 301;

- Wszystkie adresy, pod które przekierowaliśmy niepotrzebne podstrony, będą w pełni dostępne dla Google: będą generować kod odpowiedzi „200” oraz dyrektywę „Dofollow” i „Doindex”;

- W linkowaniu wewnętrznym naszego serwisu pozbyliśmy się odnośników do przekierowanych adresów URL i zastąpimy je adresami, na które zostały przekierowane;

- Na stronie nie pojawiły się nowe adresy, spoza listy tych ustalonych do pozostawiania w serwisie;

- Plik Sitemap.xml został uaktualniony o wprowadzone zmiany.

Podsumowanie

Optymalizacja crawl budgetu nie jest tak naprawdę niczym nowym w świecie SEO. Codzienna praca nad polskimi serwisami wskazuje jednak, że dalej sporo pozostało do poprawienia. Cześć wynika ze stosowania przestarzałej już strategii SEO, część z podejmowanych nieświadomych decyzji.

Optymalizacja crawl budgetu nie jest niestety prostym przedsięwzięciem. Często specjalista SEO musi rozpocząć współpracę od przekonania klienta do usunięcia 80% jego portalu (sic!). Potem zaczyna się najtrudniejsza część pracy. Polega ona na właściwym podzieleniu serwisu na cześć użyteczną z punktu widzenia SEO oraz na to, co jest balastem dla strony. Po wykonaniu prac koncepcyjnych ostateczny sukces operacji zależy od działu IT oraz szybkiej weryfikacji jego pracy ze strony specjalisty SEO.

W optymalizacji crawl budgetu nie wystarczy zatem sama wiedza. Konieczna jest także umiejętność ukucia wspólnego języka z klientem, poznanie specyfiki jego branży oraz prowadzenie efektywnej komunikacji z działem IT odpowiedzialnym za wprowadzenie zmian na stronie.

Mimo trudności optymalizacja crawl budgetu jest przedsięwzięciem, bez którego nasza strona nie poprawi swoich wyników w Google. Jeżeli pozostawimy ją w takiej sytuacji, to jedynie „pomagamy” konkurencji, która nie jest nieobciążona niezoptymalizowanym crawl budgetem.