Poprawne zaimplementowanie piksela

Prace na nowych kontach zaczynam zazwyczaj od sprawdzenia piksela i zbierania przez niego danych. Bywa różnie. Zdarza się, że wszystko jest wdrożone poprawnie i możemy skakać z radości – zostaje nam wdrożenie nowych pomysłów i testowanie. Czasami konieczne są małe poprawki. A bywają też sytuacje, gdzie okazuje się, że „wartość zamówienia” oznacza tak naprawdę wartość koszyka PRZED dokonaniem płatności, a zdarzenie zlicza się dwa — lub kilkakrotnie więcej razy niż powinno.

I nie chodzi nawet o to, że dane są zakłamane. Jeśli wiemy, że dodań do koszyka jest dwa razy więcej, niż powinno, możemy w prosty sposób to skorygować. Poza tym każde narzędzie przypisze sobie konwersje odrobinę inaczej i choć mamy tutaj więcej informacji, niż na przykład przy wpływie billboardu drogowego na sprzedaż w e-sklepie, to wciąż są to tylko pewne kalkulacje, a 1+1 nie zawsze wyniesie 2. Liczby, które mają się zgadzać, to liczby rzeczywiste w systemie CRM firmy.

Zobacz również

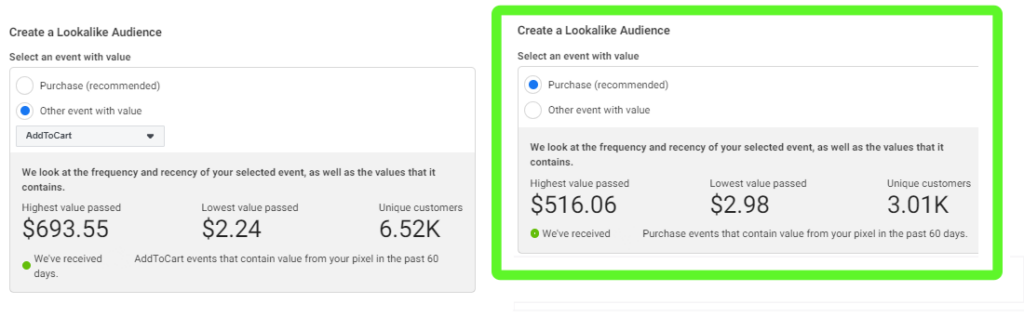

Problemem jest jednak to, że gdy system dostaje nieprawdziwe dane, to nie może też się poprawnie zoptymalizować. W kampanii, której celem jest wzrost dodań do koszyka, a są one zliczane źle – algorytm ma utrudnione zadanie. Jeśli tworzymy listę lookalike na podstawie wartości koszyka przed dokonaniem zakupu, będzie ona również mniej miarodajna niż utworzona na podstawie wartości aktualnego zakupu.

Tak więc poprawiajmy. Nawet jeśli oznacza to, że koszt konwersji wzrośnie o 59,5%, a liczba zakupów zmaleje o 77%, według wskazań panelu narzędzia (liczby nieprzypadkowe, porównujące wyniki miesiąc do miesiąca po wprowadzeniu poprawek w zliczaniu się danych).

Wskazówka: Poprawne wdrożenie piksela jest w dużej mierze zależne od budowy strony – czasami uruchomienie piksela po dokonaniu zakupu może być niemożliwe (np. gdy użytkownik po dokonaniu płatności nie przechodzi na stronę z podziękowaniem, tylko zamyka przeglądarkę lub gdy nie da się ze strony z podziękowaniem wyciągnąć sumy zakupu). Warto przyjrzeć się dokładnie, jak wygląda ścieżka zakupowa i jak zachowuje się na niej użytkownik.

Różowy Październik w rytmie jogi – marka Kinderkraft łączy CSR z angażującym doświadczeniem konsumenckim

Niby mamy gorsze wyniki, ale… lepszą jakość

Choć wzrost kosztu za wynik potrafi spędzić sen z powiek, warto spojrzeń na temat szerzej. Wyobraźmy sobie sytuację, że w wersji A mamy 100 leadów. Niestety tylko 10 z nich jest dla nas wartościowych. Pracownik musiał również zweryfikować dużą liczbę kontaktów, co kosztowało go dużo pracy. W wersji B za taką samą kwotę pozyskaliśmy tylko 50 leadów, z czego 10 z nich jest dla nas wartościowych. Pracownik miał więcej czasu, aby na spokojnie porozmawiać z osobą po drugiej stronie. Oczywiście, nadal dużo zostawionych leadów to pomyłki w stylu: „ja tylko chciałem e-booka za darmo”, „nie pamiętam, że coś uzupełniałem”, ale na to wpływ mamy dość ograniczony.

Słuchaj podcastu NowyMarketing

Mogę podać tu też inny, konkretny przykład. Po dokonaniu zmian w formularzu lead ads, porównując dane miesiąc do miesiąca, koszt za lead wzrósł o 20%. Liczba leadów w obu wypadkach była bardzo zbliżona — także pracochłonność po stronie Customer Service była na tym samym poziomie. Choć na pierwszy rzut oka wyniki te wyglądają na negatywne… to gdy wróciliśmy do tych danych po dłuższym czasie, okazało się, że mimo wyższego kosztu udało się podpisać większą ilość umów, a koszt pozyskania końcowego klienta był niższy o 60%.

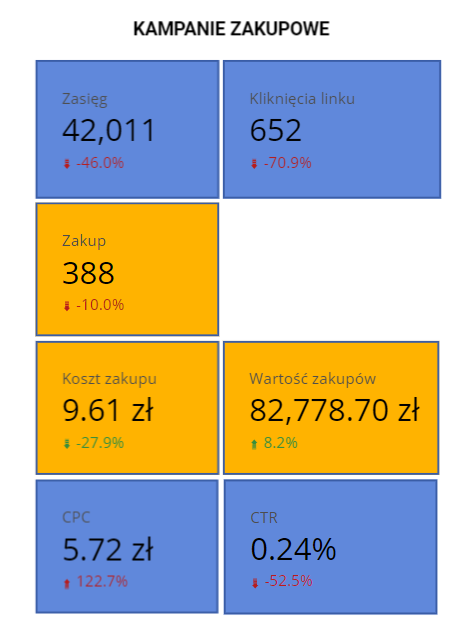

A co gdyby nagle spadła nam w sklepie liczba zakupów, ale za to wzrosła wartość koszyka? Choć czerwona strzałka przy koszcie za zakup i liczbie zakupów wygląda alarmująco, to warto najpierw zweryfikować, czy finansowo i tak nie jesteśmy „na plusie”.

Wskazówka: wiedza na temat jakości leadów jest ważna dla wszystkich osób biorących udział w ich pozyskaniu. Im bardziej szczegółowe informacje, tym lepiej. Nawet jeśli użytkownik nie weźmie oferty (zdecyduje się na inną, zmienił zdanie) dla algorytmu nadal jest to jakościowy lead (odebrał telefon, rzeczywiście świadomie uzupełnił formularz). Dzielmy się informacjami — oczywiście w zakresie zgodnym z administracją danych osobowych.

Całokształt i testowanie

Gorsze wyniki w przypadku jednej lub kilku kampanii mogą również oznaczać… że na koncie pojawiło się coś nowego, co częściowo zabrało wyniki „tam”. Dodajemy na przykład nową kampanię Advantage+, która ma 3 razy lepsze wyniki ROAS niż kampania standardowa, a w tym samym czasie kampania standardowa traci 30% swoich wyników. W dodatku dopiero co uruchomiliśmy tę kampanię, całkiem nową, na małym budżecie, więc ta strata 30% mimo wszystko jest dość mocno odczuwalna. Jednak dzięki takim zmianom, testowaniu nowych rozwiązań, możemy się rozwijać i nie stać w miejscu. Nie każdy test też wyjdzie pozytywnie – ale bez niego, nie dowiemy się o tym.

Innym przykładem jest porównanie kampanii remarketingowej do prospectingu. Remarketing ma zazwyczaj dużo lepsze wyniki pod kątem liczby zakupów i kosztów zakupu, ale… bez działań prospectingowych po prostu po jakimś czasie przestałby działać. Warto zwracać uwagę nie tylko na kwestię naszego najważniejszego KPI względem każdej aktywnej kampanii, ale także na pomniejsze, które pozwalają dojść do naszego celu. Czyli nawet jeśli produkt A ma wysoki koszt zakupu, to mając wiele dodań do koszyka… może warto go zachować. Może po prostu rozpoczyna ścieżkę klienta, a może – wyniki zgarnia dedykowana kampania do osób, które dodały, ale jeszcze nie dokonały zakupu.

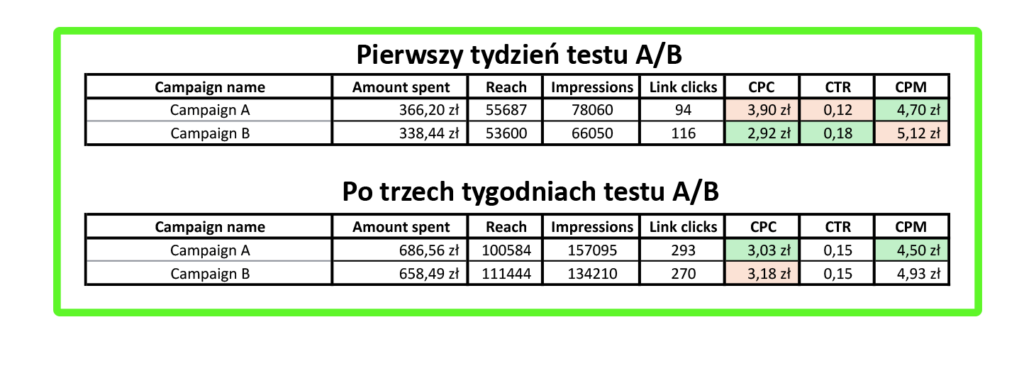

Wskazówka: nawet jeśli na początku testu widać pewną tendencję — poczekaj! Zdarza się, że nowa kampania na początku działa super, a już po tygodniu jej wyniki spadają. Niekiedy jest i odwrotnie. W wypadku kampanii w systemie Meta standardowo za adekwatny czas testu uznaje się dwa tygodnie, ale są kampanie, które dopiero po 3 tygodniach stabilizują się. Jest to również uzależnione od rodzaju kampanii i ilości danych.

Bywa różnie

W jednym z prowadzonych przeze mnie projektów wyniki w ciągu miesiąca poleciały na łeb na szyję… a przyczyny takiego stanu rzeczy były ciężkie do określenia. Właściwie nie zmieniło się w ustawieniach tak wiele, aby miało to aż tak wpłynąć na kampanie, nie stwierdziliśmy też żadnych czynników zewnętrznych, które mogły zaważyć w tak znaczący sposób. Owszem, bardziej skupiliśmy się na klientach B2B niż B2C, więc wzrost kosztu kliknięcia czy konwersji na stronie był przewidywalny, ale nie do aż takiego stopnia. Tym bardziej, że w łatwy sposób potrafiliśmy sobie porównać kampanie B2C i B2B osobno, zamiast porównywać dane dla całego konta.

Okazało się, że wyniki u klienta są świetne, i dawno tak dobrych nie miał. Tylko użytkownicy, zamiast konwertować na stronie – zaczęli po prostu składać więcej pytań mailowych i telefonicznych. A te właśnie, odpowiednio zaopiekowane, skonwertowały. System o tym nie wiedział, nie miał takich danych, nie zawsze było też wiadomo, skąd użytkownik przyszedł (tu pozwolę sobie na dygresję brzmiącą: „gdzie system nie może, tam Biuro Obsługi pomoże”. Klienci, zapytani wprost, skąd dowiedzieli się o produkcie, chętnie udzielali odpowiedzi. W efekcie, choć czekała nas długa droga pozwalająca na połączenie tego wszystkiego w całość (tak, aby system mógł z tego czerpać) – złe wyniki oznaczały, że w systemie CRM w rzeczywistości jest dobrze!

Podsumowując – tylko spokój może nas uratować

Choć to ważne, aby reagować i analizować dane, istotne jest też, aby nie stracić przy tym głowy. Działania marketingowe to progres, a nie stanie w miejscu. To normalne, że nie w każdym miesiącu będą wzrosty, co więcej, nie wszystkie spadki oznaczają coś złego.

Warto pamiętać o jeszcze jednej zasadzie: rozmawiajmy! Wielu z nas nie pyta, bo boi się wyjść na niekompetentnych – podczas gdy czasami pewne rzeczy można interpretować poprawnie, a jednocześnie na różne sposoby. Niekiedy nie wiemy, że powinniśmy o coś zapytać – nie wiemy, czego nie wiemy. Pomocne są w tym kick-offy przed startem projektu, dodatkowe „wsady” od klienta na temat danych z wewnętrznych systemów CRM czy warsztaty strategiczne. Wszystkie te działania pomagają nam poznać się wzajemnie i spojrzeć na dany aspekt pod różnymi kątami.