Od kilku miesięcy obserwujemy, jak świat zachwyca się sztuczną inteligencją. Zaczynamy ją wykorzystywać do tworzenia grafik, tekstów, projektowania stron internetowych. A kiedy Wy po raz pierwszy sięgnęliście po AI przy swoich projektach?

Kuba Matyka i Kamila Staszczyszyn z melt immersive studio: Początek zeszłego lata spędziliśmy w trybie fascynacji generatywnymi ilustracjami – sprawdzeniem możliwości, szukaniem granic, łączeniem tematów i stylów. To była bardzo uzależniająca forma ekspresji i ujścia kreatywności, od której ciężko było się oderwać. Ach te noce spędzone z Midjourney!

Założyliśmy konto na Instagramie @melt.ai, które miało być pamiętnikiem naszych generowanych obrazków, ale z dnia na dzień zaczęliśmy ich robilić po prostu za dużo. Szybko zaczęło nam też brakować ruchu. To nie była już jednak znana z DALL-E czy Midjourney ścieżka: prompt → kilka sekund → efekt. To był eksperymentalny proces ujarzmienia opensource’owych narzędzi i ich rozwijania. Generowania tripowych animacji z pomocą Disco Diffusion i dostrajania wszelkich ustawień oraz parametrów modelu tak, żeby kolejna klatka choć trochę przypominała lub wynikała z poprzedniej.

Zobacz również

Wyświetl ten post na Instagramie

Meta ożywia profile: Facebook wprowadza animowane zdjęcia dzięki AI

Zaraz potem przyszło przerabianie tym samym modelem AI materiałów wideo i tak – poza własnymi dziełami i eksperymentami – zaczęliśmy robić efekty AI do teledysków, a nawet reklam.

Słuchaj podcastu NowyMarketing

Pierwszym poważnym wyzwaniem był klip realizowany dla elektronicznego trio PNAU z udziałem Troya Sivana (wokalista, ale i aktor znany obecnie z głośnego serialu „The Idol” produkowanego przez The Weeknd dla HBO). Troye sam nagrał swoją partię na smartfonie w pokoju hotelowym, a ówczesne narzędzia AI zupełnie nie pozwalały na to, by „utrzymać” jego twarz w ryzach. Kompletnie nie radziły sobie też z ruchem ust. Efektem jest bardzo psychodeliczny klip, w którym gdzie tylko się dało, musieliśmy wklejać z powrotem fragmenty prawdziwej twarzy.

To kamień milowy od pierwszego klipu, jaki robiliśmy, czyli remiks DJ-a BLIK-a utworu nath – „nowe dni” ft. Kacha. To w 100% przerobiony klip oryginalnego numeru.

Postęp i szybkość rozwoju, zarówno technologii, jak i naszych umiejętności w jej wykorzystywaniu, najlepiej widać na przykładzie naszego konta na Instargramie, które osiągnęło zupełnie inny poziom i jakość prezentowanych prac (obecnie 140 tys. followersów i 16 mln zasięgów w ostatnich 45 dniach).

Specjalizujecie się w immersyjnych projektach. Czy AI otworzyło przed Wami nowe możliwości, jeśli chodzi o pomysły i kreację?

Przede wszystkim otworzyło bardziej nasze głowy. Po pierwsze na możliwości, a po drugie na to, co zaraz nadejdzie, czyli wykładniczy rozwój i ogromna demokratyzacja narzędzi. Każdy będzie mógł zaraz zrobić to, co kiedyś wymagało pracy zespołu specjalistów z wielu dziedzinach.

Nasze immersyjne projekty to głównie doświadczenia łączące świat realny z wirtualnym – zbudowane i odbierane w prawdziwym świecie. Ich skala sprawia, że pracuje nad nimi sztab specjalistów i wykorzystane są tony multimedialnego sprzętu. Choć AI od dawna jest upchane wewnątrz silników renderujących czy Unreal Engine, to nie wpływało na nic poza szybkością i jakością pracy.

Wspomagamy się trochę przy naszych pracach koncepcjami ChatGPT i czasem coś „naszkicujemy” albo zwizualizujemy w Midjourney, ale nie zrewolucjonizowało to naszego procesu kreatywnego. Poszerzyło tylko zestaw narzędzi.

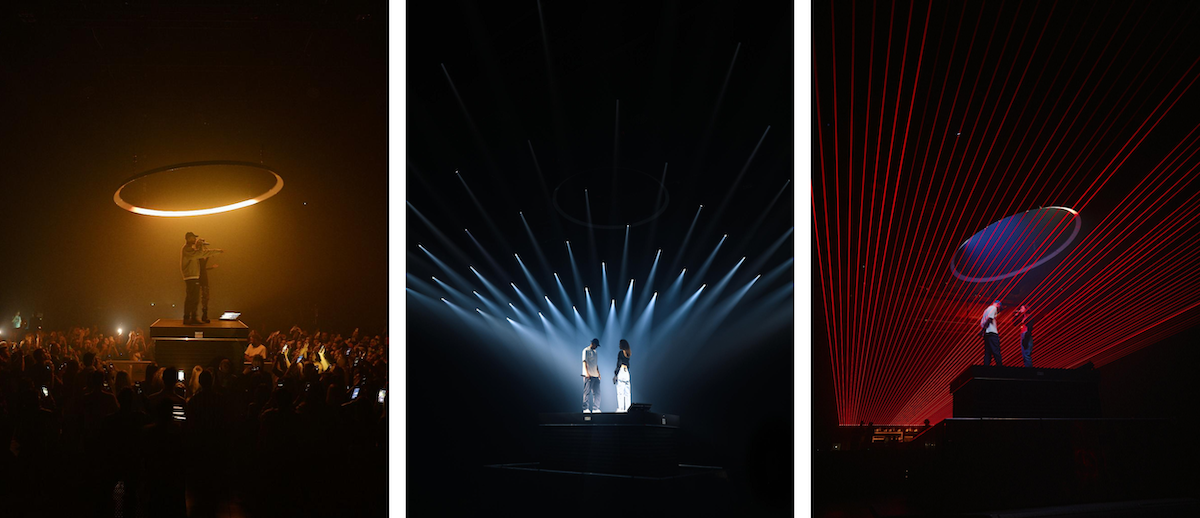

Wyobraźmy sobie koncert dwóch gwiazd na dwóch przeciwległych scenach, a pomiędzy nimi publiczność i instalacja z setek świateł i laserów nad nimi wszystkimi. Artyści grają na zmianę, a tłum ludzi co piosenkę przelewa się spod jednej sceny pod drugą, prowadzony przez audiowizualne animacje „przejścia” – kończąc na trzeciej, środkowej scenie niespodziance, na której artyści wspólnie wynieśli się nad publiczność wykonując wspólny utwór. Nasz zeszłoroczny koncert duetu artystów w ramach Mastercard Music to efekt kilku lat zajawki przestrzennymi instalacjami new media art, wielkiej chęci wyjściu ze sceny do odbiorców oraz wielu tygodni przygotowań, projektowania, animacji i programowania – AI na ten moment jeszcze za dużo nie pomoże.

Wasze najnowsze dzieło to teledysk powstały w wyniku połączenia sił z międzynarodowymi gwiazdami muzycznymi: PNAU, Bebe Rexha i Ozuna. Jaki procent pracy wykonanej został przez AI, a jaki przez człowieka?

Niestety (albo stety) to wciąż w większości praca ludzka. Warstwa AI zmienia stworzony przez nas obraz (najpierw nagranie, a potem klasyczne efekty specjalne) o około 30%. To bardzo ważne 30%, bo decyduje o dużej części finalnego wyglądu i detali, ale w ramach tych 30% jest też oczywiście masa ludzkiej pracy.

W tym przypadku postawiliśmy sobie wyzwanie stworzenia wizualnej historii mniej abstrakcyjnej niż przy poprzednich projektach. Wymyśliliśmy światy, w które chcieliśmy zabrać widzów i postaci, w które zamienili się artyści. Proces preprodukcji i filmowania odbywał się zupełnie normalnie – może poza wygenerowaniem większej ilości concept artów w AI… żeby artyści byli świadomi, w co się pakują!

Aby to osiągnąć, musieliśmy wymyślić nowe sposoby i techniki „reżyserowania” oraz kontrolowania AI. Każdy, kto kiedykolwiek próbował generować obrazy za pomocą AI, wie, jak trudno jest sprawić, aby sztuczna inteligencja zrobiła dokładnie to, czego chcemy. Jeszcze trudniej jest uzyskać spójne wyniki na kilku obrazach. Wyobraźcie sobie teraz, że musisz sprawić, aby to działało dla wszystkich 4200 klatek filmu. I „przy okazji” opowiedziadało spójną wizualnie narrację.

Przykładowo – bazując na Stable Diffusion musieliśmy trenować własne modele AI na wizerunkach artystów, by byli rozpoznawalni, a ich twarze nie „morphowały” losowo pomiędzy setkami nieistniejących osób. Krótki materiał beyond the scene z całego procesu można zobaczyć tutaj.

Co ciekawe, przy tempie rozwoju technologii, wykorzystane wtedy techniki i narzędzia AI są już nieco przestarzałe, a efekt bardziej „poklatkowy” niż to, co robimy teraz. I uwaga, klip był realizowaliśmy w grudniu zeszłego roku.

Czy podzielacie zdanie, że AI zastąpi wkrótce pracowników kreatywnych? Czy wkrótce wszystkie teledyski będą powstawał na komputerze jednej osoby, bez konieczności zatrudniania szeregu specjalistów?

Teledyski już od lat mogą i powstają na komputerach pojedynczych osób – wszystko zależy od zaangażowania, włożonej pracy i czasem talentu. Ciekawym jest jednak fakt, że przed zeszłorocznym boomem na generatywne obrazki, społeczeństwo myślało, że kreatywność to będzie ostatni bastion ludzkości w świecie, w którym pozostałe techniczne i manualne zawody zostaną wyparte przez sztuczną inteligencję i roboty. Przewrotnie najpierw przyszła kolej na branżę kreatywną.

Świat i rozwój technologiczny przyspieszają w takim tempie, że kompletnie nie jesteśmy w stanie przewidzieć, co będzie w przyszłości. Naszym zdaniem AI szybko nie zastąpi pracowników kreatywnych. To nowe narzędzie w naszym arsenale, ale rola człowieka – jako „zleceniodawcy” zadań i „kuratora” efektów – jest kluczowa i niepodważalna dla powstania jakiegokolwiek dzieła.

Czyli tzw. rzemieślnicy, którzy bazują na „odręcznej”, autorskiej pracy (ilustratorzy, malarze, pisarze) nie muszą się martwić o pracę?

Uważam, że artyści i rzemieślnicy, którzy już mają lub wypracują swój własny styl (coś, co ich odróżnia od ogółu) będą zawsze w cenie. Gorzej niestety z ludźmi odpowiedzialnymi za projekty generyczne lub opierające się na modzie. Widzieliśmy to już w historii wiele razy podczas demokratyzacji innych technologii. Przykładem niech będzie malarstwo → fotografia → fotografia cyfrowa → aparat w każdym smartfonie. Każdy może namalować obraz lub zrobić zdjęcie, ale wciąż jaramy się ludźmi, którzy robią to wyjątkowo.

AI to bez wątpienia ogromne szanse na przyspieszenie i uproszczenie pracy, a także zmniejszenie kosztów, ale czy widzicie jakieś zagrożenia wynikające z rozpowszechniania tej technologii?

Nie będę tu pewnie oryginalny, zagrożone są prawa autorskie i ogólnie prawo, które nie nadąża za rozwojem technologii. Są też zagrożenia społeczne takie jak bezrobocie, problem edukacji i idąca za tym potencjalna potrzeba zmian systemowych.

Właśnie – co z tymi prawami autorskimi? Czy spodziewacie się regulacji prawnych, które być może ograniczą nam tę możliwość dowolnego wykorzystywania dzieł AI?

USCO, czyli urząd ds. praw autorskich w USA (US Copyright Office) wydał opinię, że grafika w 100% wygenerowana za pomocą prompta (tekstowej instrukcji) nie może zostać chroniona prawem autorskim (copyright). Za utwór może zostać uznany wyłącznie efekt kreatywnej pracy człowieka.

Inaczej natomiast jest, gdy człowiek ma ewidentny wpływ na powstanie dzieła – czy to zmieniając oryginalny utwór (grafika, zdjęcie, video etc.) z pomocą AI, modyfikując „ręcznie” efekty uzyskane z pomocą AI, czy też tworząc dzieło z wielu elementów wygenerowanych z pomocą AI (np. komiks).

To trochę łatanie dziury w prawie na szybko i kierunek, który będzie coraz bardziej problematyczny i rozmyty – coraz trudniej będzie to rozdzielić i ocenić, gdzie kończy się narzędzie, a zaczyna człowiek.

Wyświetl ten post na Instagramie

Czy Waszym zdaniem agencje reklamowe, które nie będą korzystać z możliwości AI, wkrótce „wypadną z obiegu”?

AI to teraz buzzword, ale machine learning już kryje się za większością cyfrowych narzędzi i serwisów internetowych. Zaraz po prostu nie będzie się dało nie korzystać z możliwości AI. Najbliższym wszystkim przykładem jest Adobe Photoshop – program wprowadzający ostatnio przyspieszające pracę generatywne narzędzia w błyskawicznym tempie.

W październiku 2023 roku w centrum Warszawy otwarte zostanie melt museum z immersyjną wystawą działająca na wszystkie zmysły zwiedzających. Opowiecie coś więcej o tym projekcie?

Otwarcie takiego miejsca to nasze marzenie od lat. Większość naszych projektów jest tymczasowa i kosztowna w produkcji, co sprawia, że na żywo może je zobaczyć tylko niewielka liczba osób. Strasznym uczuciem jest „zawijanie” efektu kilkumiesięcznej pracy po dwóch dniach.

Dlatego tworzymy immersyjną przestrzeń w Warszawie, która będzie przybliżać gościom sztukę nowych mediów i immersyjną rozrywkę. Przekraczając tradycyjne pojęcie „muzeum”, zaoferujemy unikalne doświadczenia opartych na interakcji, odkrywaniu i audiowizualnej podróży angażującej zmysły. Pierwsza stała wystawa będzie poświęcona przyszłości i AI, ale w nieco bardziej cyberpunkowej sci-fi oprawie.

Oczywiście wywodząc się z branży kreatywnej i rozrywkowej, mamy w planach nienachalne partnerstwa z markami i artystami świata muzycznego, a także możliwości wynajmu w pełni wyposażonej multimedialnie przestrzeni na potrzeby eventowe.

PS Artystyczne kody QR – nowy trend w świecie AI

Entuzjaści sztucznej inteligencji dali się ponieść nowemu trendowi – zajęli się generowaniem artystycznych kodów QR, które wyglądają jak małe dzieła sztuki. Oczywiście takie kody są cały czas funkcjonale i przenoszą użytkowników na konkretne strony internetowe. Jak je zrobić?

PS 2 NAOKO zaprezentowało pierwszą kolekcję zaprojektowaną przez społeczność marki przy pomocy AI

Marka zadbała o atrakcje na najwyższym poziomie, oferując jedyny w swoim rodzaju NAOKO VR EXPERIENCE, dzięki któremu NAOKO.AI była na wyciągnięcie ręki.