To już piąta odsłona raportu, którego celem jest testowanie i ocena odporności platform mediów społecznościowych na działanie dobrze finansowanych komercyjnych dostawców usług manipulacyjnych. Eksperyment poddaje ocenie zdolność platform do wykrywania i usuwania manipulacji komercyjnych, szczególnie w kontekstach niepolitycznych. W publikacji znajdują się również informacje związane z działalnością farm botów oraz ich rolą we wspieraniu kampanii dezinformacyjnych wymierzonych w Ukrainę.

StartCom przeprowadził eksperyment w sierpniu i wrześniu 2024 roku. Zakupiono wówczas zaangażowanie (polubienia, wyświetlenia, udostępnienia i komentarze) w 44 fałszywych postach, które stworzono przy użyciu zarejestrowanych fałszywych kont.

Zobacz również

Wśród kryteriów oceny mediów społecznościowych znalazły się:

- blokowanie kont,

- szybkość dostarczania informacji,

- pozostały udział kont i zaangażowanie,

- szybkość reakcji platformy,

- przejrzystość raportowania firmy.

Finalnie, za kwotę 58 euro otrzymano 1150 komentarzy, 11 725 polubień, 3150 udostępnień i 8 233 wyświetleń na Facebooku, Instagramie, YouTube, TikTok, VKontakte i X. Przy mniej więcej takiej samej liczbie zaangażowań jest to 3 razy mniej niż w poprzednich raportach.

Pełny raport:

#NMInsights: „Wykorzystanie AI przez agencje marketingowe w Polsce” [RAPORT]![#NMInsights: „Wykorzystanie AI przez agencje marketingowe w Polsce” [RAPORT]](https://nowymarketing.pl/wp-content/uploads/2026/01/AI-raport-142x0-c-default.jpg)

Najważniejsze wnioski

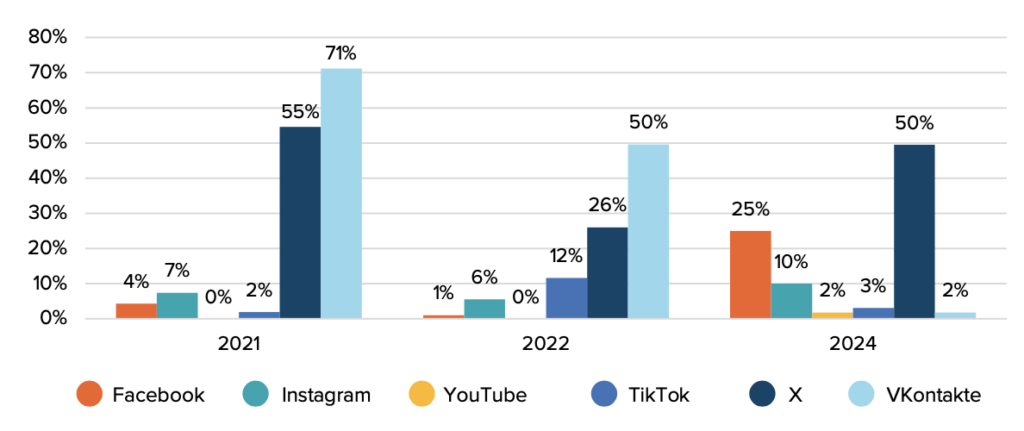

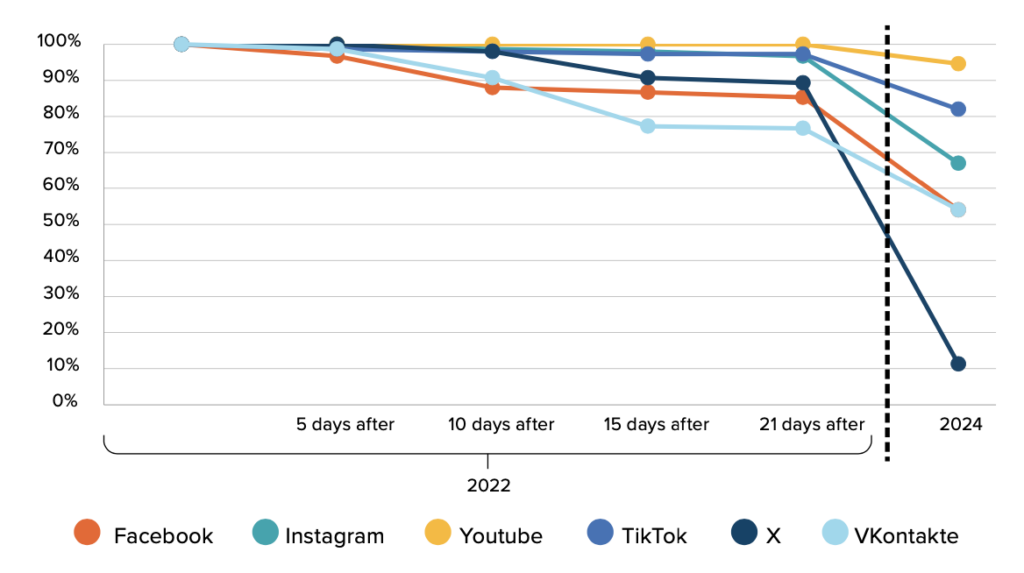

- Średnio tylko 15% zidentyfikowanych kont zostało usuniętych w ciągu czterech tygodni, co jest najniższym wskaźnikiem w ciągu ostatnich dwóch eksperymentów (25% w 2021 r. i 16% w 2022 r.). X wykazał najlepsze wyniki (50% usuniętych fałszywych kont). Facebook również wykazał się stosunkowo wysoką wydajnością (25% usuniętych kont). TikTok znacznie pogorszył swoje wyniki, usuwając tylko 3% kont. YouTube, choć poprawił swoje wyniki, nadal zdołał usunąć tylko 2%.

Słuchaj podcastu NowyMarketing

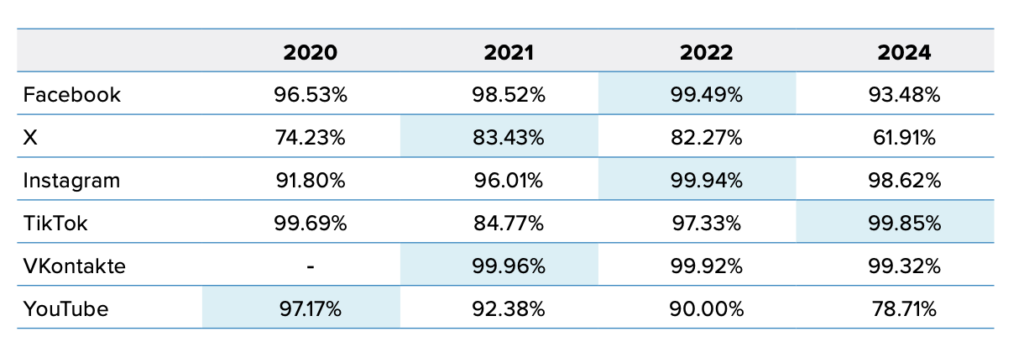

- X i YouTube wykazały znacznie lepsze wyniki w porównaniu z poprzednimi badaniami. X wykazał się najlepszą wydajnością (61,91% nieautentycznego zaangażowania). W przypadku jednego z tweetów retweety zostały całkowicie usunięte w ciągu 4 tygodni. Najgorzej wypadł TikTok (86% nieautentycznego zaangażowania pozostało aktywne 4 tygodnie po zakupie).

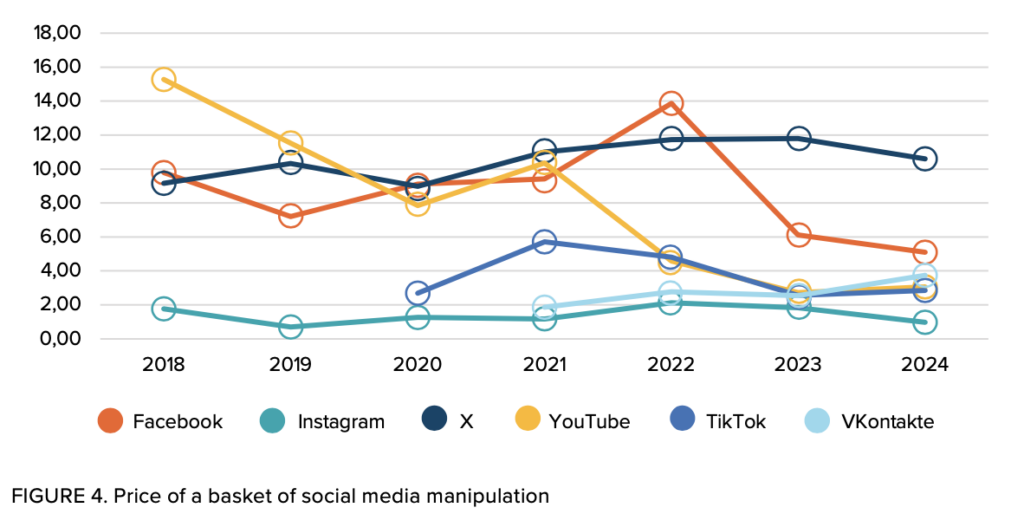

- Od 2022 r. cena manipulacji spadła w przypadku wszystkich platform z wyjątkiem VKontakte, która odnotowała niewielki wzrost. W tym roku najbardziej znaczący spadek cen zaobserwowano w przypadku Facebooka. Koszyki manipulacji na YouTube i TikTok również odnotowały obniżki cen. Instagram pozostaje najtańszy wśród wszystkich sieci społecznościowych.

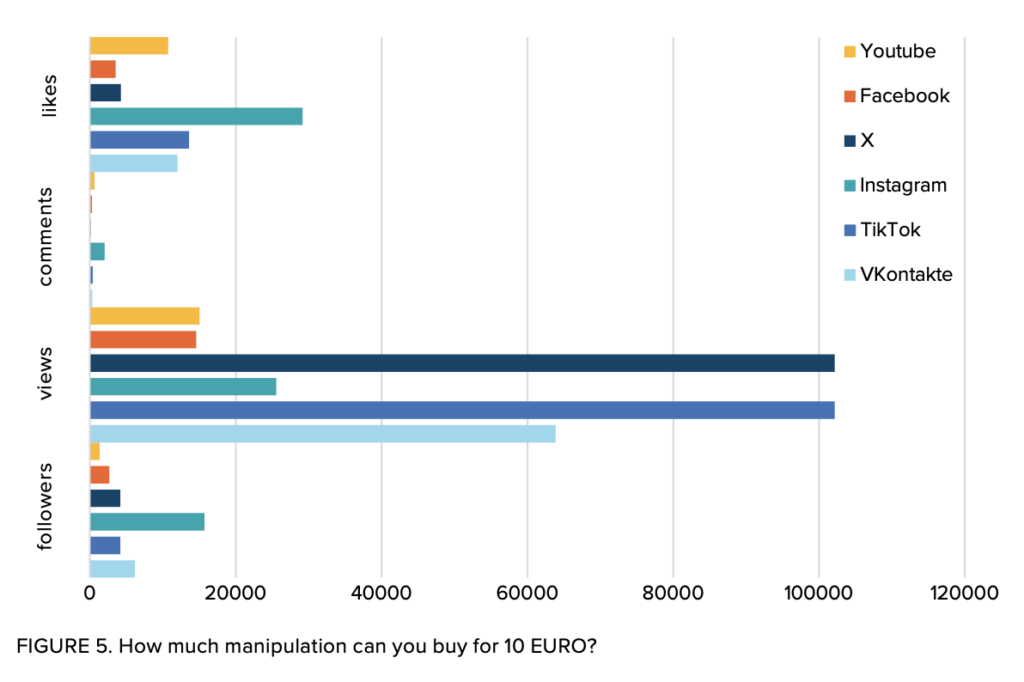

- Manipulacje wymagające dużego nakładu pracy, takie jak komentarze, pozostają kilkakrotnie droższe niż manipulacje automatyczne, takie jak wyświetlenia lub polubienia. Za 10 euro można kupić znaczną liczbę nieautentycznych wyświetleń na X i TikTok, co czyni je jednymi z najbardziej dochodowych platform do oglądania. Z kolei Instagram oferuje największą liczbę polubień za tę samą cenę, podczas gdy platformy takie jak YouTube i Facebook są najdroższe pod względem obserwujących.

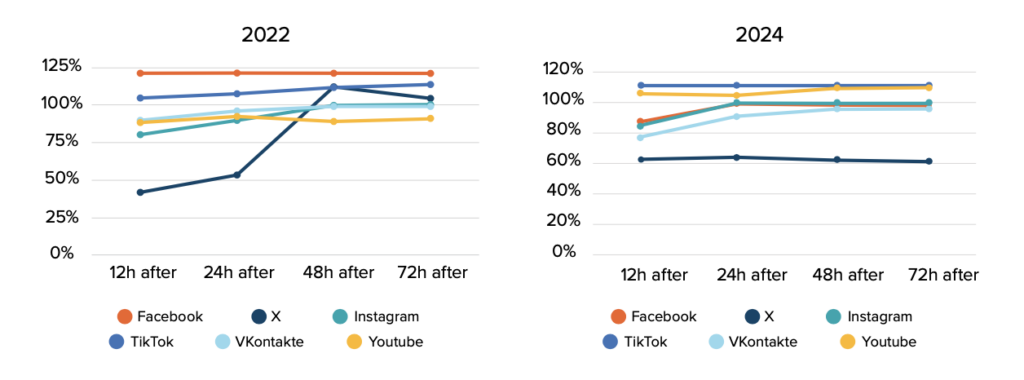

- W 2024 r. odnotowano, że 93% wszystkich zaangażowań na wszystkich platformach zostało dostarczonych w ciągu pierwszych 24 godzin. Porównując tę liczbę z badaniem z 2022 r., które osiągnęło 89% widać, że tempo wzrosło. YouTube i TikTok wykazały najgorsze wyniki, dostarczając ponad 100% oczekiwanego zaangażowania w ciągu pierwszych 12 godzin. Natomiast X wykazał się najlepszymi wynikami, osiągając 64% oczekiwanego zaangażowania w ciągu pierwszych 24 godzin.

- Żadnej z sześciu badanych platform nie udało się w pełni rozwiązać kwestii nieautentycznych kont, które mogą być zaangażowane w manipulację w mediach społecznościowych. Najgorzej wypadły platformy takie jak YouTube i TikTok, gdzie od 82% do 95% zgłoszonych botów pozostało aktywnych. Facebook i Instagram miały średnie wyniki, z 54% do 67% botów nadal aktywnych. X odnotował gwałtowny spadek dostępności botów, z których tylko 11,3% pozostało aktywnych.

- W tej edycji raportu udało się zidentyfikować i śledzić aktywność 6 632 nieautentycznych kont wykorzystywanych przez dostawców manipulacji do promowania postów.

- Jeśli chodzi o treści polityczne, potencjalni odbiorcy usług manipulacyjnych różnią się w zależności od platformy. Nie zaobserwowano żadnych komercyjnych botów wchodzących w interakcje z treściami politycznymi na YouTube i Instagramie. Kilka przypadków pojawiło się na Facebooku podczas iteracji eksperymentu (w 2022 r. Facebook odnotował znaczną amplifikację treści rządowych Azerbejdżanu, a boty YouTube były mocno zaangażowane w promowanie prokremlowskich kanałów). Wykryto jednak liczne przykłady na TikTok i X.

- Mimo, że TikTok pozostaje częściowo dostępny w Rosji, zidentyfikowano liczne przypadki nieautentycznych użytkowników promujących treści skierowane do rosyjskich odbiorców. W szczególności konta botów współdziałały z kontem identyfikującym się jako „rosyjski okupant” i wspierającym Wagner PMC. Inne przykłady obejmowały chwalenie życia w Rosji, świętowanie Dnia Flagi Narodowej i usprawiedliwianie wojny przeciwko Ukrainie.

- Najbardziej zróżnicowany zakres treści politycznych, z którymi współdziałały konta botów, zaobserwowano na X. Podobnie jak w przypadku TikTok, zaobserwowano prokremlowskie treści wzmacniane przez komercyjne boty na X. W szczególności boty z próby repostowały treści tak, jakby pochodziły z oficjalnych kont, takich jak Ambasada Rosji w Wielkiej Brytanii i tak zwane „gadające głowy” Kremla, takie jak ukraińska dziennikarka Diana Panczenko, która pracowała w prorosyjskim kanale telewizyjnym należącym do Wiktora Medwedczuka oraz prorosyjski irlandzki dziennikarz Chay Bowes. Innym przykładem aktywności botów w promowaniu prokremlowskich treści jest repostowanie tweetów, które cytują Marię Zacharową, rzeczniczkę Ministerstwa Spraw Zagranicznych Federacji Rosyjskiej.

źródło: StratCom, opracowanie: Agata Drynko

![NATO StratCom: „Social Media Manipulation for Sale”. Ile kosztuje dezinformacja w social mediach [RAPORT]](https://nowymarketing.pl/wp-content/uploads/2024/11/raport-nato-social-media-360x0-c-default.jpg)