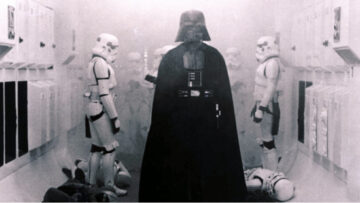

Niewykorzystane dane stały się Dark Data. Na domiar złego Rebelianci rozpowszechniali nieprawdziwe informacje, które miały wprowadzić wywiadowców Imperium w błąd – generowali tzw. Dirty Data, które Imperium często łykało jak młody pelikan. To właśnie te dwa oblicza danych, Dark Data i Dirty Data, przesądziły o klęsce Imperium. Gwiezdne Wojny to przede wszystkim film o blaskach i cieniach analityki danych w firmie. Nawet takiej, jak Gwiazda Śmierci.

Moc jest w danych

Wcale nie tak dawno temu, we wcale nie tak odległej galaktyce danych zwanej Internetem, doszło do wielkiego wybuchu Big Data, którego skutki odczuwamy do dziś. Dane zalały Sieć, a ich produkcja wymknęła się czyjejkolwiek kontroli. Internet zaczął obrastać w Big Data niczym Jabba the Hutt w tłuszczyk. Według Oracle dzisiejszy Internet rozrasta się w dane w tempie 40 proc. w skali roku.

Zobacz również

Gdyby Vader zdecydował się te dane krążące po galaktyce analizować i wdrożył Big Data na Gwieździe Śmierci, imperialni badacze danych bez większego trudu dokopaliby się do informacji, że np. taki Luke Skywalker (syn i przyszły pogromca Vadera) żyje na Tatooine. Porywając go stamtąd, szturmowcy zmieniliby bieg historii. Odkryliby też, że Leia to siostra Luke’a. Tak samo sprawa przedstawia się z odszukaniem i unieszkodliwieniem nieuchwytnego Obi Wana Kenobiego, który ukrywał się pod jakże zaskakującą tożsamością: Ben Kenobi. Brnijmy dalej: gdyby załoga Gwiazdy Śmierci gromadziła i przetwarzała dane o obywatelach Starej Republiki (tworzyła ich profile behawioralne), to bez trudu znalazłaby w ich gronie tych niezadowolonych, których – dzięki spersonalizowanym komunikatom – mogłaby zwerbować do pracy ku chwale Imperium. Gdyby Imperium zbierało dane od szturmowców dotyczące słabych elementów ich ekwipunku, to nie padaliby jak muchy. Gdyby na bieżąco monitorowało ruchy wojsk Republiki, to nie pozwoliłoby się zaskoczyć.

I jeszcze jedna sprawa: gdyby Vader wiedział, że dostęp do wiarygodnych danych i ich bezpieczeństwo przesądzi o losach Imperium, zatrudniłby ludzi, którzy nie tylko w pełni poświęciliby się budowaniu i szyfrowaniu własnych baz danych, lecz także oczyszczaniu strumienia danych generowanych przez Sojusz Rebeliantów z nieprawdziwych informacji, wyławiając ich faktyczne plany i zamiary.

Wniosek jest prosty – jeśli marzy nam się (biznesowe) imperium, to powinniśmy nie tylko analizować Big Data, lecz także stawić czoło jej innym twarzom: Dark Data i Dirty Data. Czym właściwie są? Skąd się wzięły? I czy za ich sprawą czekają nas „cyfrowe mroczne wieki”?

Więcej niż precyzyjne targowanie. Poznaj gigantyczne możliwość audience data

Witajcie w mrocznych, brudnych czasach

Źli bracia bliźniacy. Tak najkrócej można określić Dark Data oraz Dirty Data, czyli dwie ciemne strony Big Data, które zalewają dziś Internet. „Mroczne” (Dark) i „Brudne” (Dirty) dane spędzają sen z powiek analitykom i marketerom, sabotując ich żmudną pracę. Problem jest poważny, ponieważ według szacunków IDC około 90 proc. danych w Internecie to właśnie „mroczne dane”, a blisko 10 proc. wszystkich danych w mediach społecznościowych – to z kolei „brudne dane”.

Słuchaj podcastu NowyMarketing

W lutym tego roku „Ojciec Internetu” i wiceprezydent Google, Vinton Gray Cerf, przemawiając do zgromadzonych w San Jose członków American Association for the Advancement of Science, mówił m.in. o konieczności bieżącej pracy nad danymi, które już zgromadziliśmy: „Digitalizujemy rzeczy, ponieważ myślimy, że dzięki temu to je uchroni. Nie rozumiemy jednak, że jeśli nie podejmiemy kolejnych kroków, to zdigitalizowane przez nas rzeczy mogą nawet okazać się gorsze od swoich rzeczywistych pierwowzorów”. Cerf mówiąc o kolejnych krokach, miał na myśli przede wszystkim ciągłą weryfikację prawdziwości i aktualności danych, czyli jednego z czterech V tworzących Big Data – Veracity (obok Volume, Variety i Velocity).

Przede wszystkim jednak „Ojciec Internetu” ostrzegał przed nadchodącymi „cyfrowymi, ciemnymi wiekami”. Jako główny katalizator „Digital Dark Age” wymienił implozję danych (Big Data), zdominowanych przez Dark Data, czyli dane nieuporządkowane, nieustrukturyzowane, nieprzetworzone, surowe. Podkreślał, że to właśnie inwazja Dark Data jest dziś największym wyzwaniem stojącym przed analitykami danych. Od wyniku tej konfrontacji zależała będzie przyszłość wielu cyfrowych biznesów.

Mroczne imperium kontratakuje

Mroczność Dark Data polega nie tylko na tym, że są one zbiorem chaotycznym, lecz również na tym, że na dobrą sprawę nie wiadomo, co w sobie kryją. Mogą być jak puszka Pandory, mogą być jakimś zlepkiem cyfrowych nostalgii – ale mogą też okazać się garnkiem złota znalezionym na końcu tęczy, ponieważ będą zawierały informacje, które z powodzeniem organizacje mogą zmonetyzować bądź wykorzystać je do uzyskania pełnej, 360-stopniowej oceny profilu klienta.

Poziom Dark Data danych liczy się już w Zettabajtach. Sieć wg. obliczeń Oracle ma już przeszło 5,2 ZB danych (Big Data), ale raptem 10 proc. z nich przedstawia sobą realną wartość, czyli jest realnie wykorzystywanych. Pozostałe 90. proc. to według IDC Dark Data, czyli dane, z których organizacje nie robią żadnego użytku, a niekiedy po prostu nie wiedzą, jak można by je wykorzystać.

Dlatego albo firmy gromadzą je w surowym stanie tak „na wszelki wypadek”, „na zapas”, „na później”, łudząc się, że przyjdzie czas na ich analizę – albo w ogóle je ignorują i puszczają wolno, nie wiedząc, jak się do nich zabrać lub widząc w takim przedsięwzięciu syzyfową pracę. Wskutek takiego postępowania wiele potencjalnie cennych informacji ginie w cyfrowych mrokach, stając się dla następnych pokoleń już tylko hieroglifami, których sens jest niemożliwy do odczytania.

Dark Data – spojrzeć w czarną otchłań danych

Dark Data to wciąż stosunkowo słabo eksplorowany obszar, nie tylko w sensie praktycznym, ale i teoretycznym. O „mrocznych danych” wiemy mało, toteż definicje „Dark Data” czasami poważnie się od siebie różnią.

Gartner w swoim słowniczku IT („Gartner IT Glossary”) definiuje Dark Data jako: „Zasoby informacyjne, gromadzone i przetwarzane przez organizacje podczas ich codziennej aktywności biznesowej, które na ogół nie nadają się do wykorzystania w żadnym sensownym celu”. Jednak Cory Janssen z Techopedii mówi coś nieco innego: „Dark data to rodzaj nieustrukturyzowanych, nieotagowanych i niewykorzystanych danych, które zalegają w repozytoriach danych i nie są analizowane ani przetwarzane. Można je znaleźć w plikach dziennika (log files) oraz archiwach danych, przechowywanych w dużych przedsiębiorstwach”. Widać jak na dłoni, że te dwie definicje są ze sobą sprzeczne w jednym punkcie. Gartner mówi o „przetwarzaniu Dark Data”, zaś Techopedia głosi coś odwrotnego. Kto zatem ma rację?

Bliżej prawdy jest chyba Techopedia, choć nawet jej definicja nie oddaje w pełni złożoności problematyki Dark Data. „Mroczne dane” można bowiem opisać w potrójny sposób. Po pierwsze – są to dane, z których istnienia przedsiębiorstwo w ogóle nie zdaje sobie sprawy, więc ani ich nie gromadzi, ani nie przetwarza (tu definicja Gartnera bierze w łeb). Po drugie – mogą to być dane, o których przedsiębiorstwo wie i je gromadzi, lecz nie ma pojęcia, jak je przetworzyć. Po trzecie – to również dane, o których istnieniu przedsiębiorstwo wie i nawet dysponuje narzędziami do ich analizy, lecz jej nie podejmuje, ponieważ uznaje ją za zbyt kosztowną lub obawia się, że jej rezultaty będą niewspółmierne z nakładem pracy, jaki trzeba było w nią włożyć. Dopiero połączenie każdej z tych skrawkowych definicji daje jakąś szerszą perspektywę tego, czym jest „Dark Data”. Żeby zatem zamknąć tę kwestię przyjmijmy perspektywę biznesową, wedle której „Dark Data” to dane, które (z różnych powodów) nie są monetyzowane przez organizacje.

Talk Dirty to me

O ile Dark Data można by określić jako „zmarnowany potencjał”, o tyle już drugiego złego brata bliźniaka, czyli Dirty Data, wypadałoby opisać raczej jako internetowego trolla Big Data Marketingu.

Z Dark Data wciąż można wyłowić jakieś sensy, wzorce i zależności. Mroczne dane można jeszcze jakoś rozświetlić, jeśli dysponuje się odpowiednimi narzędziami do analityki. W przypadku Dirty Data zaś mamy do czynienia z totalnym cyfrowym bełkotem. Brudne dane można jedynie wyszorować czy wyprać, tzn. usunąć je z tkaniny, jaką jest Big Data. Są jak brzydkie plamy po winie na białej koszuli.

Gdzie można się na nie natknąć? Najciemniej pod latarnią. Media społecznościowe – głównie Facebook – to największe generatory i kopalnie danych o internautach. Nic dziwnego, że wiele firm ma klapki na oczach i koncentruje się na analizie danych wyłącznie stąd, ponieważ są one najłatwiej dostępne. Bazując tylko na takich informacjach (lajki, komcie, szery, tagi, hashtagi zgromadzone na fanpejdżach itp.), przedsiębiorstwo układa swoją strategię marketingową. A to poważny błąd. Ponieważ lwia część danych z portali społecznościowych jest po prostu „brudna”. To Dirty Data, dane zanieczyszczone. Według analiz Networked Insights blisko 10 proc. takich danych jest do wyrzucenia, ponieważ… wcale nie pochodzą od realnych użytkowników. Są zasługą sztucznych botów (53%), skutkiem ruchu generowanego przez spamerów, celebrytów lub osoby opłacane przez konkurencyjne firmy (23%) bądź przez nieaktywne konta (11%). W wyniku tego zatruwania danych wytwarza się „Dirty Data”. „Brudne dane” wprowadzają w błąd przede wszystkim marketerów, ponieważ dostarczają bezużytecznej pseudo-wiedzy.

Już teraz od 50 do nawet 80 proc. czasu, jaki badacze danych spędzają w firmach nad analizą Big Data, pochłania właśnie oczyszczanie danych z „Dirty Data”. W żargonie analitycznym określa się to jako „janitor work”, czyli pracę „dozorcy” czy „woźnego” danych, choć pasowałoby tu raczej określenie: „dirty job”. Jest co robić, ponieważ według DOMO tylko w ciągu minuty użytkownicy samego Facebooka tworzą 2 460 000 nowych treści. Dlatego praca „janitorsów” przypomina zmywanie podłogi na korytarzu, na kilka sekund przed dzwonkiem na długą przerwę w szkole.

Niepokojące jest to, że udział „brudnych danych” w ogólnym strumieniu Big Data w Sieci w porównaniu z ubiegłym rokiem wzrósł aż o 658 proc. Niektóre marki przyznają wprost, że nawet 90 proc. postów na ich fanpejdżach w mediach społecznościowych spokojnie mogą zaklasyfikować jako wiadomości-śmieci. Dirty Data zanieczyszczają wartościowe Big Data, które stanowią dla marketerów najważniejsze źródło informacji o fanach czy klientach, ponieważ dotyczą ich intencji, gustów czy zachowań. Oznacza to, że marki, które w swojej strategii komunikacyjnej bazują wyłącznie na Big Data z mediów społecznościowych i w żaden sposób nie dywersyfikują źródeł danych, muszą liczyć się z możliwością napotkania zwodniczego „Dirty Data”, a co za tym idzie – wypaczenia profilu fana (lub klienta). Nie będą w stanie zdiagnozować: które dane są tymi przydatnymi? Tak samo jak załoga Gwiazdy Śmierci nie mogła się rozeznać: co jest prawdą, a co fałszem wytwarzanym przez rebeliancki strumień danych?

Żeby nie brudzić rączek

Z uwagi na lawinowo generowaną ilość Big Data w galaktyce internetu i w social media, analiza takich ilości danych przekracza zdolności nie tylko zwykłego człowieka, ale i tradycyjnych systemów informatycznych. Jest jak niekończąca się pustynia na Tatooine.

Zamiast tracić czas i siłować się z „brudnymi” oraz „mrocznymi” danymi na własną rękę, lepiej zostawić sprawę fachowcom, badaczom danych, którzy na co dzień stykają się ze strumieniem Dirty & Dart Data, ale w nim nie toną. Na powierzchni utrzymują ich specjalistyczne narzędzia analityczne, jak np. silnik behawioralny, który analizuje anonimowe dane o użytkownikach wielopłaszczyznowo i z wielu źródeł. Polscy marketingowcy mają pod ręką choćby BehavioralEngine, silnik posiadający wbudowanego Antybota, pozwalającego z łatwością oddzielić ziarno od plew, czyli „Dirty Data” od „Big Data”. Gromadzi on dane z ponad pół miliona stron www, zna preferencje oraz zachowania przeszło 40 mln unikalnych profili użytkowników i buduje ich profile na podstawie 5 tysięcy szczegółowych atrybutów. Dziennie przetwarza ponad 5 TB danych, a przede wszystkim: konwertuje Dirty Data do Big Data, dzięki czemu marki mają możliwość faktycznego rozeznania się co do profilu swojego fana lub klienta. Bez ryzyka, że otrzymane profile cyfrowe będą skażone „brudem” czy „mrokiem”. Te oczyszczone i wiarygodne dane wykorzystywane są później choćby w spersonalizowanej reklamie internetowej, ale nie tylko tam.

Gdyby badacze danych z Gwiazdy Śmierci posiadali taki silnik – Imperium byłoby potęgą nie do ruszenia. A tak okazało się tylko kolosem na glinianych nogach.

Światło, mydło i powidło

W Cloud Technologies wierzymy, że sukces każdej organizacji zależy od tego, jak obchodzi się ona z danymi: Big Data, Dark Data, Dirty Data. Wierzymy, że zlekceważenie analityki internetowej i sprowadzenie jej do poziomu jakiegoś przejściowego trendu czy geekowskiej fanaberii, odbija się organizacjom biznesową czkawką. Wierzymy, że dane to nowa waluta epoki cyfrowej, która z biegiem lat będzie się umacniać. I mamy na to twarde dowody. Według badań Gartnera wydatki na analitykę danych rosną w tempie dwucyfrowym. Do 2017 roku 30 proc. danych, jakimi będą dysponowały przedsiębiorstwa, będzie pochodziło z hurtowni Big Data. IDC podaje, że już teraz 70 proc. dużych firm posiłkuje się danymi o użytkownikach gromadzonymi i przetwarzanymi przez zewnętrzne platformy Big Data. Do 2019 roku według IDC tym tropem pójdą już wszystkie duże organizacje. Coraz więcej firm będzie także monetyzować własne Big Data, podwajając inwestycje w analitykę Big Data oraz wyszukując unikatowych danych, które pozwolą im na uzyskanie biznesowej przewagi nad konkurencją.

Wierzymy i wiemy, że póki co nikt nie wynalazł skuteczniejszej strategii niż Big Data Marketing.

Wierzymy, że Dark Data w końcu ujrzy światło analityki. A Dirty Data – jej mydło.

Niech moc danych będzie z Wami.

Łukasz Kapuśniak

Chief Big Data Officer w Cloud Technologies

Jedi Big Data Marketingu i Boba Fett Analityki Internetowej

Pogromca Ciemnej Strony Danych